- Введение в анализ данных на Python для начинающих

- Что такое анализ данных?

- Что такое Pandas?

- Структуры данных в Pandas

- Анализ данных в Pandas

- Введение в анализ данных с помощью Pandas

- Основные структуры данных и их загрузка

- Базовые операции с наборами данных

- Агрегация данных

- Заключение

- Как провести анализ данных в Python

- Основные библиотеки

- Начало работы

- Загрузка данных

- Предобработка данных

- Анализ данных

- Выводы

Введение в анализ данных на Python для начинающих

Наука данных является обширной областью исследования с большим количеством областей, из которых анализ данных является неоспоримо один из наиболее важных из всех этих областей, и независимо от своего уровня мастерства в науке данных, она становится все более важной для понимания.

Если вы новичок в Python, советуем прочитать книги по языку программирования Python

Что такое анализ данных?

Анализ данных — это обработка и преобразование большого количества неструктурированных или неорганизованных данных с целью генерирования ключевой информации об этих данных, которые могли бы помочь в принятии обоснованных решений.

Существуют различные инструменты, используемые для анализа данных, Python, Microsoft Excel, Tableau, SaS и т.Д., Но в этой статье мы сосредоточимся на том, как анализ данных выполняется в python. Более конкретно, как это делается с библиотекой Python под названием Pandas.

Что такое Pandas?

Pandas — это библиотека Python с открытым исходным кодом, используемая для манипулирования данными. Это быстрая и высокоэффективная библиотека с инструментами для загрузки нескольких видов данных в память. Его можно использовать для изменения формы, маркировки среза, индексации или даже группировки нескольких форм данных.

Структуры данных в Pandas

В Pandas есть 3 структуры данных, а именно:

Лучший способ различить три из них — это видеть, что один содержит несколько стеков другого. Итак, DataFrame — это стек Series, а Panel — это стек DataFrame.

Series — это одномерный массив.

Стек из нескольких Series составляет двухмерный DataFrame

Стек из нескольких DataFrames образует трехмерный Panel

Структура данных, с которой мы будем работать больше всего, — это двухмерный DataFrame, который также может быть средством представления по умолчанию для некоторых наборов данных, с которыми мы можем столкнуться.

Анализ данных в Pandas

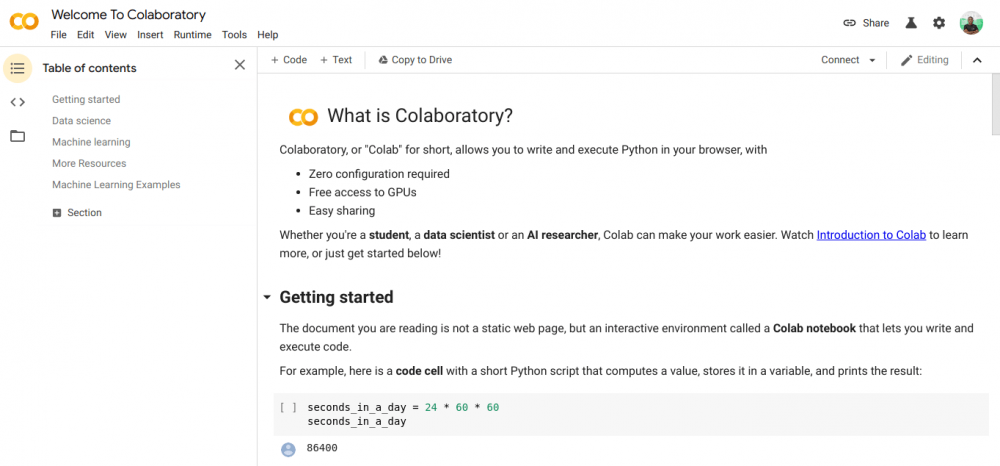

Для этой статьи какие-либо установки не требуются. Мы будем использовать инструмент под названием colaboratory, созданный Google. Это онлайн среда Python для анализа данных, машинного обучения и искусственного интеллекта. Это просто облачный Jupyter Notebook, который поставляется с предустановленным почти каждым пакетом Python, который вам понадобится как специалист по данным.

Теперь перейдите на сайт https://colab.research.google.com/notebooks/intro.ipynb. Вы должны увидеть картинку ниже.

В левом верхнем углу, выберите опцию «File» и нажмите «New notebook». Вы увидите новую страницу записной книжки Jupyter, загруженную в ваш браузер. Первое, что нам нужно сделать, это импортировать Pandas в нашу рабочую среду. Мы можем сделать это, с помощью строки:

Для этой статьи мы будем использовать набор данных о ценах на жилье для нашего анализа данных. Набор данных, который мы будем использовать, можно найти здесь. Первое, что мы хотели бы сделать, это загрузить этот набор данных в нашу среду.

Введение в анализ данных с помощью Pandas

Сегодня речь пойдет о пакете Pandas. Данный пакет делает Python мощным инструментом для анализа данных. Пакет дает возможность строить сводные таблицы, выполнять группировки, предоставляет удобный доступ к табличным данным, а при наличии пакета matplotlib дает возможность рисовать графики на полученных наборах данных. Далее будут показаны основы работы с пакетом, такие как загрузка данных, обращение к полям, фильтрация и построение сводных.

Основные структуры данных и их загрузка

from pandas import read_csv df1 = read_csv("df1.txt") df2 = read_csv("df2.txt",";") #второй аргумент задает разделитель Теперь у нас есть 2 набора данных df1, содержащий магазины и количество отгрузок:

| shop | qty |

|---|---|

| 427 | 3 |

| 707 | 4 |

| 957 | 2 |

| 437 | 1 |

И df2, содержащий магазин и его город:

| shop | name |

|---|---|

| 347 | Киев |

| 427 | Самара |

| 707 | Минск |

| 957 | Иркутск |

| 437 | Москва |

Базовые операции с наборами данных

- в набор с городами магазинов добавим поле `country` и заполним соответствующими странами

- выберем украинский магазин и поменяем его номер

- добавим магазин, полученный на предыдущем шаге, к общему списку

- добавим количество из df1 к набору df2

- построим сводную таблицу по странам и количеству отгрузок

country = [u'Украина',u'РФ',u'Беларусь',u'РФ',u'РФ'] df2.insert(1,'country',country) - номер позиции, куда будет вставлен новый столбец

- имя нового столбца

- массив значений столбца (в нашем случае, это обычный список list)

- через точку — НаборДанных.ИмяПоля

- в квадратных скобках – НаборДанных[‘ИмяПоля’]

t = df2[df2.country == u'Украина'] t.shop = 345 Результатом выполнения данного кода, будет новый промежуточный набор данных t, содержащий одну запись:

| shop | country | name |

|---|---|---|

| 345 | Украина | Киев |

Для того чтобы добавить полученную на предыдущем шаге запись, нужно выполнить функцию append(), в качестве аргумента которой передается набор данных, который нужно добавить к исходному:

Агрегация данных

Теперь к нашему основному списку магазинов df2, можно подтянуть количество из набора данных df1. Сделать это можно с помощью функции merge(), которая соединяет два набора данных (аналог join в SQL):

res = df2.merge(df1, 'left', on='shop') - набор данных (который будет присоединен к исходному)

- тип соединения

- поле, по которому происходит соединение

- список столбцов, по которым будет считаться агрегированные значение

- список столбцов, которые будут строками итоговой таблицы

- функция, которая используется для агрегации

- параметр для замены пустых значений на 0

res.pivot_table(['qty'],['country'], aggfunc='sum', fill_value = 0) Заключение

В качестве заключения хотелось бы сказать, Pandas является неплохой альтернативой Excel при работе с большими объемами данных. Показанные функции это только верхушка айсберга под название Pandas. В дальнейшем, я планирую написать серию статей в которых будет показана вся мощь данного пакета.

Как провести анализ данных в Python

Освойте анализ данных в Python с этим простым руководством: от основных библиотек до предобработки и визуализации данных!

Анализ данных в Python — это процесс изучения и обработки данных с помощью языка программирования Python для получения информации, обнаружения закономерностей или предсказания будущего поведения. В этом руководстве мы рассмотрим основные библиотеки и методы, необходимые для выполнения анализа данных в Python.

Основные библиотеки

Для анализа данных в Python существуют следующие ключевые библиотеки:

- NumPy — это библиотека для работы с массивами и матрицами. Она предоставляет множество функций для математических и статистических операций.

- Pandas — библиотека для работы с табличными данными (такими как Excel или SQL таблицы). Она предоставляет инструменты для очистки, агрегации и визуализации данных.

- Matplotlib и Seaborn — это библиотеки для построения графиков и визуализации данных.

Начало работы

Для начала установим необходимые библиотеки:

pip install numpy pandas matplotlib seaborn

Теперь импортируем их в наш Python-скрипт:

import numpy as np import pandas as pd import matplotlib.pyplot as plt import seaborn as sns

Загрузка данных

Для анализа данных нам необходимо загрузить данные в формате CSV, Excel или SQL. В этом примере мы будем использовать данные о пассажирах Титаника в формате CSV:

data = pd.read_csv("titanic.csv") Посмотрим на первые несколько строк данных:

Предобработка данных

Перед анализом данных полезно провести предобработку, чтобы удалить пропущенные значения, исправить ошибки и преобразовать данные в удобный для анализа формат. Например, мы можем заполнить пропущенные значения возраста средним возрастом пассажиров:

data['Age'].fillna(data['Age'].mean(), inplace=True)

Также можно создать новый столбец с информацией о том, был ли пассажир один или с семьей:

data['Family'] = data['SibSp'] + data['Parch']

Анализ данных

Теперь, когда наши данные предобработаны, мы можем провести анализ данных. Например, можно исследовать связь между классом каюты и вероятностью выживания:

sns.barplot(x='Pclass', y='Survived', data=data) plt.show()

Также можно изучить распределение возрастов среди выживших и погибших пассажиров:

sns.histplot(data=data, x='Age', hue='Survived', kde=True) plt.show()

Выводы

В этом руководстве мы рассмотрели основные методы и библиотеки для анализа данных в Python. Надеемся, что это поможет вам в вашей работе со сложными наборами данных! 😊

Не забудьте обратить внимание на онлайн-школу, которая учит специалистов в сфере «Аналитика данных». Вставьте в текст спец.тег

Удачи вам в изучении анализа данных!