Обработка больших данных с помощью инструментов Python

Кульматова, Н. А. Обработка больших данных с помощью инструментов Python / Н. А. Кульматова. — Текст : непосредственный // Молодой ученый. — 2023. — № 13 (460). — С. 11-14. — URL: https://moluch.ru/archive/460/101080/ (дата обращения: 28.07.2023).

В статье описывается популярный и простой в использовании язык программирования Python, используемый для обработки больших данных, и его основные библиотеки для обработки данных. Функции Python делают его идеальным для анализа данных, он прост в освоении, надежен, удобочитаем, масштабируем, имеет обширный набор библиотек, интеграцию с другими языками, а также активное сообщество и систему поддержки.

Ключевые слова : обработка данных, большие данные, Python, pandas, numpy.

The article describes Python, a widely used, easy-to-use programming language for large data processing, and its main libraries for data processing. Python’s features make it easy to learn, reliable, readable, scalable, a wide range of libraries, integration with other languages, and ideal for data analysis for an active community and support system.

Keywords : data processing, Big Data, Python, pandas, numpy.

Большие данные — это большие объемы структурированных или неструктурированных данных. Они обрабатываются специальными автоматизированными инструментами, используемыми для статистики, анализа, прогнозирования и принятия решений.

С 2014 года ведущие университеты мира делают упор на Big Data, обучая прикладным инженерным и IT-специальностям. Затем к сбору и анализу присоединились такие ИТ-корпорации, как Microsoft, IBM, Oracle, EMC, а затем Google, Apple, Facebook и Amazon. Сегодня большие данные используются крупными компаниями во всех отраслях, а также государственными структурами [1].

Необработанные данные не имеют ценности. Для преобразования и анализа больших данных требуются инструменты и языки программирования. Существует множество специальных инструментов и языков программирования, которые помогут вам автоматизировать процесс и сэкономить время.

Несколько языков программирования были разработаны для обработки больших объемов данных и они Pandas (для анализа данных) вокруг него сложилась целая экосистема библиотек и фреймворков.

Требования к программированию науки о данных требуют очень универсального, но гибкого языка, на котором легко писать код, но который может выполнять очень сложные математические операции.

Python лучше всего подходит для таких требований, потому что он зарекомендовал себя как язык как для общих вычислений, так и для научных вычислений. Кроме того, он постоянно пополняется новыми дополнениями к большому количеству библиотек, ориентированных на различные требования программирования [1].

При анализе данных и визуализации результатов Python является обязательным наряду с R, MATLAB, SAS, Stata и т. д. можно сравнить со многими языками программирования и такими инструментами, как относительно недавнее появление продвинутых библиотек для Python (прежде всего pandas) сделало его серьезным конкурентом в решении задач манипулирования данными [2].

Для работы с данными создано несколько специальных библиотек Python:

NUMPY (для численного анализа и формирования)

MATPLOTLIB (для визуализации данных)

SCIPY (для научных вычислений)

SEABORN (для визуализации данных)

TENSORFLOW (используется в глубоком обучении)

SCIKIT-LEARN (используется в машинном обучении)

Python в целом отлично подходит для анализа данных: с помощь него можно решать задачи автоматизации сбора и обработки данных и реализовать на работе новые подходы к анализу, например решать задачи с помощью обучения нейросетей.

В Pandas можно работать с данными трех структур:

— последовательности (Series) — одномерные массивы данных;

— фреймы (Data Frames) — объединение нескольких одномерных массивов в двумерный, то есть привычная таблица из строк и столбцов. Этот формат чаще всего используют аналитики;

— панели (Panels) — трехмерная структура из нескольких фреймов.

Библиотека пригодится всем, кто работает с данными, особенно аналитикам. С помощью Pandas можно группировать таблицы, очищать и изменять данные, вычислять параметры и делать выборки.

Библиотека Pandas предоставляет функции, которые упрощают и ускоряют работу со структурированными данными. Это один из ключевых компонентов, который делает Python таким мощным инструментом для анализа данных.

Pandas — отличный инструмент для обработки данных. Он предназначен для быстрой и простой обработки, чтения, интеграции и визуализации данных.

Pandas считывает данные из файлов CSV, TSV или базы данных SQL и создает объект Python со строками и столбцами, который называется DataFrame. Основным объектом в Pandas является DataFrame, двумерная таблица с помеченными строками и столбцами. DataFrame очень похож на таблицу в статистическом программном обеспечении, скажем, в Excel или SPSS [3].

- Индексация, редактирование, переименование, сортировка, объединение фреймов данных;

- Обновлять, добавлять, удалять столбцы во фрейме данных;

- Восстановление отсутствующих файлов, редактирование отсутствующих данных или NAN;

Построение графиков

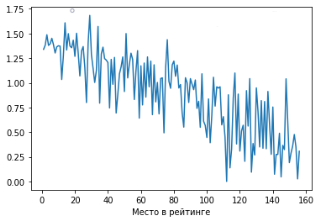

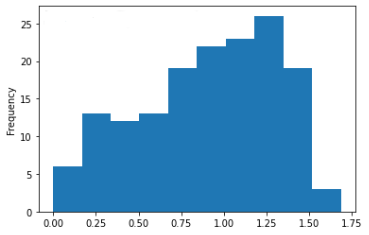

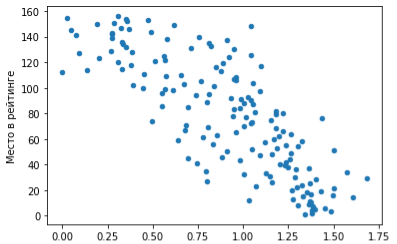

Гистограмма. Отобразим ту же зависимость в виде столбчатой гистограммы:

Мы видим предсказуемую тенденцию: чем выше ВВП на душу населения, тем ближе страна к первой строчке рейтинга.

4. Постройте линейчатую или прямоугольную диаграмму NumPy — один из самых фундаментальных пакетов Python, универсальный пакет для работы с массивами. Он предоставляет высокопроизводительные объекты многомерного массива и инструменты массива.

NumPy — это эффективный контейнер для общих многомерных данных. Базовый объект NumPy представляет собой однородный многомерный массив. Это таблица элементов или чисел одного типа данных, индексированных набором натуральных чисел. В NumPy измерения называются осями, а количество осей — рангом. Класс массива NumPy — ndarray он же array.

NumPy используется для манипулирования массивами, в которых хранятся значения одного типа данных. NumPy упрощает выполнение математических операций с массивами и их векторизацию. Это значительно повышает производительность и, следовательно, ускоряет время выполнения.

Matplotlib — визуализация данных позволяет отображать их визуально, анализировать более подробно, чем в обычном формате, и более легко представлять их другим. Matplotlib — лучшая и самая популярная библиотека Python для этой цели. Это не так просто использовать, но вы можете научиться создавать их очень быстро с помощью наиболее распространенных 4–5 блоков кода для простых линейных диаграмм и точечных диаграмм.

Функции Python делают его идеальным для анализа данных, он прост в освоении, надежен, удобочитаем, масштабируем, имеет обширный набор библиотек, интеграцию с другими языками, а также активное сообщество и систему поддержки [3].

Python предоставляет множество библиотек и редакторов для эффективного анализа данных. Python — это самый быстрорастущий язык, используемый специалистами по обработке и анализу данных Youtube, Google и другими. Он используется с целью быстрого анализа.

- Силен Дэви, Мейсман Арно, Али Мохамед. Основы Data Science и Big Data. Python и наука о данных. — СПб.: Питер, 2017. — 336 с.: ил. — (Серия «Библиотека программиста»).

- Ын Анналин, Су Кеннет. Теоретический минимум по Big Data. Всё, что нужно знать о больших данных. — СПб.: Питер, 2019. — 208 с.: ил. — (Серия «Библиотека программиста»).

- Мейсман Арно. Основы Data Science и Big Data. Python и наука о данных. 2016. — 322 c. Подробнее: https://www.labirint.ru/authors/181786/

- Top 10 Python Libraries for Data Science. https://towardsdatascience.com/top-10-python-libraries-for-data- science-cd82294ec266

- https://blog.skillfactory.ru/kak-nachat-analizirovat-dannye-v-pandas-pervye-shagi/

- https://practicum.yandex.ru/blog/pandas-dlya-analiza-dannyh/

продукт компании Meta, которая признана экстремистской организацией в России.

Основные термины (генерируются автоматически): анализ данных, данные, визуализация данных, обработка данных, язык программирования, CSV, EMC, IBM, активное сообщество, обширный набор библиотек.

Как работать с большими наборами данных в Python: 3 способа

Исследователям данных часто приходится работать с достаточно объемными наборами данных, которые трудно обработать компьютеру. Эта проблема не нова и, как и любая другая, не имеет универсального решения. Лучший выход из положения будет зависеть от конкретных данных и задач приложения. И все же попытаемся выделить из три наиболее оптимальных решения.

1. Сокращение используемой памяти путем оптимизации типов данных

При загрузке данных с использованием Pandas типы определяются автоматически (если не указана иная задача). В большинстве случаев этот подход работает отлично, но выводимый тип не обязательно будет оптимизирован. Более того, если числовой столбец содержит отсутствующие значения, то автоматически вычисляемый тип будет float .

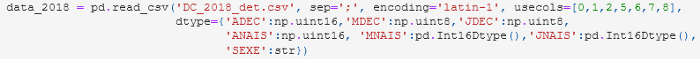

Недавно я использовала этот метод для анализа в основном целочисленных типов данных, представляющих годы, месяцы и дни:

В данном случае определение типов данных привело к значительному сокращению используемой памяти. Обратите внимание, что в приведенном примере с помощью pandas.Int16Dtype я принудительно определила тип int для столбца, содержащего отсутствующие значения. Это достигается внутренним использованием pandas.NA, вместо numpy.nan, для недостающих значений.

Оптимизация типов данных при работе с наборами больших данных требует предварительного изучения. Вряд ли этот способ окажется полезным на исследовательской фазе обработки неизвестного набора.

2. Разделение данных на фрагменты

Когда данные слишком велики, чтобы поместиться в памяти, можно воспользоваться опцией Pandas chunksize . Она позволяет разделить данные на фрагменты вместо того, чтобы работать с одним большим блоком. При использовании этой опции создается объект-итератор, с помощью которого можно просматривать различные фрагменты и выполнять фильтрацию или анализ точно так же, как при загрузке полного набора данных.

Вот пример использования этой опции для просмотра набора данных обзоров Yelp, извлечения данных о минимальном и максимальном времени обзоров в каждом блоке, а затем установления полного временного интервала, потребовавшегося для обзоров:

reader = pd.read_json(reviews_path, lines=True, orient = "records", chunksize = 100000)

# прохождение по блокам и извлечение мин./макс. времени

date_limits = []

for chunk in reader:

date_limits.append(max(chunk.date))

date_limits.append(min(chunk.date))

print("Reviews span from <> to <>".format(min(date_limits).strftime('%d-%m-%Y'),

max(date_limits).strftime('%d-%m-%Y')))Этот метод может применяться на всем пути работы с данными — от предварительного эксплораторного анализа до обучения модели. При этом потребуется минимум дополнительных настроек.

3. Использование преимуществ ленивых вычислений

Ленивые вычисления относятся к стратегиям, позволяющим отложить операцию вычисления до того момента, когда возникнет реальная необходимость в результате. Ленивые вычисления — важная концепция, особенно полезная для функционального программирования.

На основе ленивых вычислений построены такие механизмы распределенных вычислений, как Spark и Dask. Они предназначены для работы с кластерами, но пригодятся и для обработки больших массивов данных на компьютере.

В отличие от Pandas, они не загружают данные непосредственно в память. Вместо этого, во время чтения происходит сканирование данных, вывод их типов и разбиение их на разделы. Вычислительные графы для этих разделов строятся независимо и выполняются только тогда, когда это действительно необходимо (отсюда и название “ленивые вычисления”).

Pyspark используется для выполнения эксплораторного анализа набора данных, превышающих объем памяти компьютера. Dask также довольно популярен, примеры его применения найти несложно. Синтаксис Dask имитирует синтаксис Pandas, так что он будет выглядеть очень знакомым. Однако, если Dask ограничен использованием Python, то Spark также будет работать с Java и Scala.

Аналогичные возможности предлагают такие библиотеки, как Vaex и Modin.