- Извлечение HTML страниц

- Извлечение HTML страниц в один файл. Используйте HTML Page Extractor с любого устройства с браузером.

- Нажмите на страницы, которые вы хотите обработать.

- Ваш файл успешно обработан

- Отправить ссылку на скачивание

- О приложении Extractor

- Как извлечь страницы из HTML документа онлайн

- Вопросы и ответы

- Язык гипертекстовой разметки

- Извлекать страницы из других файлов

- 11 фишек для извлечения и сохранения данных с сайтов

- 1. Скачиваем сайт целиком для просмотра оффлайн

- 2. Прикидываем сколько на сайте страниц

- 3. Устанавливаем ограничения на скачивание страниц сайта

- 4. Скачиваем с сайта файлы определенного типа

- 5. Скачиваем только определенные папки

- 6. Решаем вопрос с кодировкой

- 7. Делаем снимок веб-страницы

- 8. Сохраняем картинки только с определенной страницы

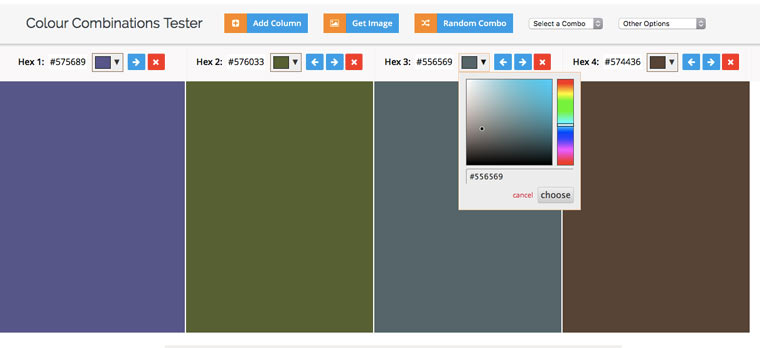

- 9. Извлекаем HEX-коды цветов с веб-сайта

- 10. Извлекаем из текста адреса электронной почты

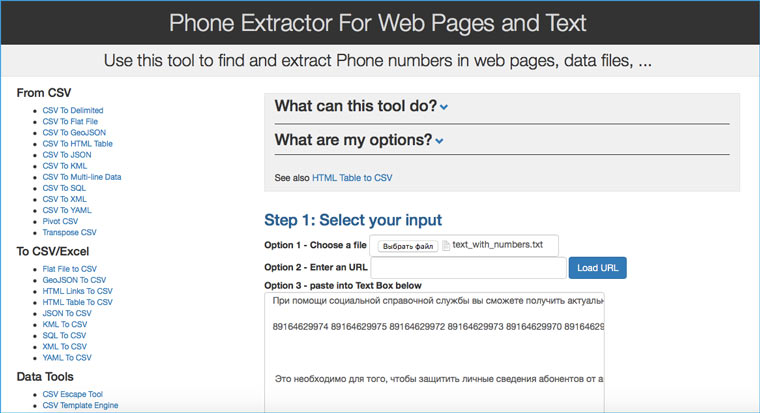

- 11. Извлекаем из текста номера телефонов

- HTML парсер

- Узнайте больше о бесплатном онлайн приложении GroupDocs.Parser!

- Язык гипертекстовой разметки

- Как извлечь текст и метаданные из файлов HTML

- Другие форматы, поддерживаемые Parser App

Извлечение HTML страниц

Извлечение HTML страниц в один файл. Используйте HTML Page Extractor с любого устройства с браузером.

Загружая файлы или используя наш сервис, вы соглашаетесь с нашими Условиями использования. и Политикой конфиденциальности.

Нажмите на страницы, которые вы хотите обработать.

Ваш файл успешно обработан

Отправить ссылку на скачивание

О приложении Extractor

Извлекайте страницы из HTML документа быстро и легко. Бесплатный онлайн-инструмент Extract HTML Pages без регистрации создан для быстрого извлечения страниц из HTML файла. Вам не нужно тратить свое время на выполнение этих операций вручную на настольном программном обеспечении. Наша цель — предоставить вам надежное решение для оптимизации рабочего процесса вашего офиса с помощью онлайн-приложения Extract HTML Pages. Все HTML файлы обрабатываются на наших серверах, поэтому никаких дополнительных плагинов или установки программного обеспечения не требуется. Он мощный, современный, быстрый, гибкий, простой в использовании и полностью бесплатный.

- Легкое извлечение HTML страниц документа

- Извлечение страниц из HTML файла

- Загрузка или отправка результирующего файла в виде вложения электронной почты

Как извлечь страницы из HTML документа онлайн

Вопросы и ответы

Прежде всего, вам нужно выбрать и добавить HTML файл для извлечения страницы двумя способами: перетащить ваш HTML файл в белую область с меткой «Нажмите или перетащите свой файл сюда» или нажмите на эту область, а затем выберите нужный HTML файл с помощью проводника. Как только файл будет добавлен, зеленый индикатор выполнения начнет расти. После завершения процесса можно нажать кнопку Сохранить, а затем загрузить файл результата HTML.

Да, ссылка для скачивания файла результат HTML будет доступна только вам. Загруженный файл будет удален через 24 часа, а ссылка для загрузки перестанет работать по истечении этого периода времени. Никто не имеет доступа к вашему файлу. Экстрактор страницы документа HTML абсолютно безопасен.

Да, вы можете использовать наш бесплатный HTML Document Page Extractor на любой операционной системе, в которой есть веб-браузер. Наш HTML Document Page Extractor работает онлайн и не требует установки какого-либо программного обеспечения.

Для извлечения страниц из HTMLфайла можно использовать любой современный браузер, например, Google Chrome, Microsoft Edge, Firefox, Opera или Safari.

Язык гипертекстовой разметки

HTML (Hyper Text Markup Language) — это расширение для веб-страниц, созданных для отображения в браузерах. HTML, известный как язык Интернета, развивался с учетом новых требований к информации, которая должна отображаться как часть веб-страниц. Последний вариант известен как HTML 5, что дает большую гибкость для работы с языком. HTML-страницы либо принимаются с сервера, на котором они размещены, либо также могут быть загружены из локальной системы.

Извлекать страницы из других файлов

Можно также извлекать страницы из других форматов файлов. Пожалуйста, ознакомьтесь со списком ниже.

11 фишек для извлечения и сохранения данных с сайтов

В закладки

БЕЗ скриптов, макросов, регулярных выражений и командной строки.

Эта статья пригодится студентам, которые хотят скачать все картинки с сайта разом, чтобы потом одним движением вставить их в Power Point и сразу получить готовую презентацию. Владельцам электронных библиотек, которые собирают новые книги по ресурсам конкурентов. Просто людям, которые хотят сохранить интересный сайт/страницу в соцсети, опасаясь, что те могут скоро исчезнуть, а также менеджерам, собирающим базы контактов для рассылок.

Есть три основные цели извлечения/сохранения данных с сайта на свой компьютер:

- Чтобы не пропали;

- Чтобы использовать чужие картинки, видео, музыку, книги в своих проектах (от школьной презентации до полноценного веб-сайта);

- Чтобы искать на сайте информацию средствами Spotlight, когда Google не справляется (к примеру поиск изображений по exif-данным или музыки по исполнителю).

Ситуации, когда неожиданно понадобится автоматизированно сохранить какую-ту информацию с сайта, могут случиться с каждым и надо быть к ним готовым. Если вы умеете писать скрипты для работы с утилитами wget/curl, то можете смело закрывать эту статью. А если нет, то сейчас вы узнаете о самых простых приемах сохранения/извлечения данных с сайтов.

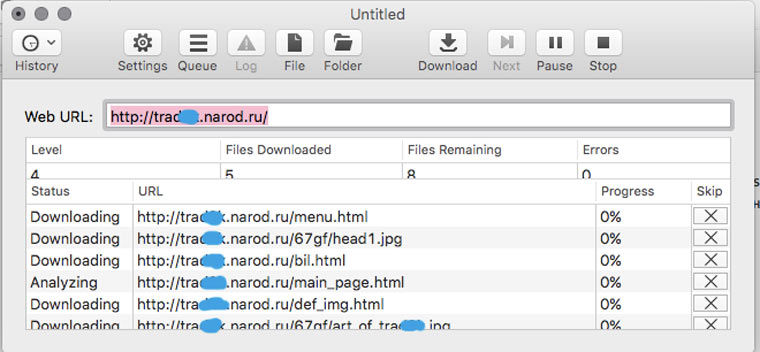

1. Скачиваем сайт целиком для просмотра оффлайн

В OS X это можно сделать с помощью приложения HTTrack Website Copier, которая настраивается схожим образом.

Пользоваться Site Sucker очень просто. Открываем программу, выбираем пункт меню File -> New, указываем URL сайта, нажимаем кнопку Download и дожидаемся окончания скачивания.

Чтобы посмотреть сайт надо нажать на кнопку Folder, найти в ней файл index.html (главную страницу) и открыть его в браузере. SiteSucker скачивает только те данные, которые доступны по протоколу HTTP. Если вас интересуют исходники сайта (к примеру, PHP-скрипты), то для этого вам нужно в открытую попросить у его разработчика FTP-доступ.

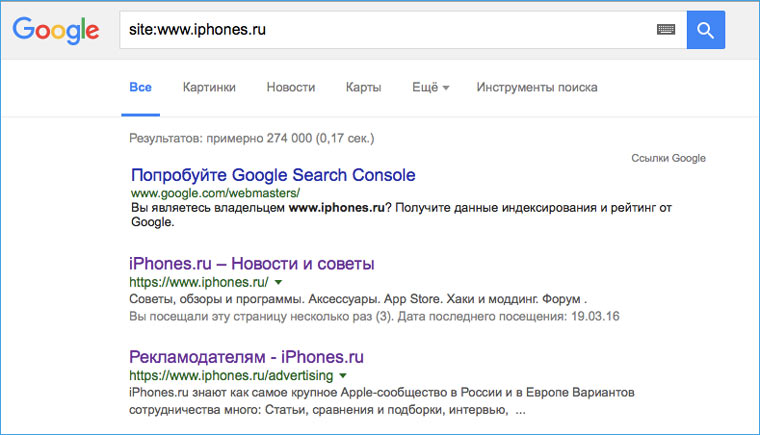

2. Прикидываем сколько на сайте страниц

Перед тем как браться за скачивание сайта, необходимо приблизительно оценить его размер (не затянется ли процесс на долгие часы). Это можно сделать с помощью Google. Открываем поисковик и набираем команду site: адрес искомого сайта. После этого нам будет известно количество проиндексированных страниц. Эта цифра не соответствуют точному количеству страниц сайта, но она указывает на его порядок (сотни? тысячи? сотни тысяч?).

3. Устанавливаем ограничения на скачивание страниц сайта

Если вы обнаружили, что на сайте тысячи страниц, то можно ограничить число уровней глубины скачивания. К примеру, скачивать только те страницы, на которые есть ссылка с главной (уровень 2). Также можно ограничить размер загружаемых файлов, на случай, если владелец хранит на своем ресурсе tiff-файлы по 200 Мб и дистрибутивы Linux (и такое случается).

Сделать это можно в Settings -> Limits.

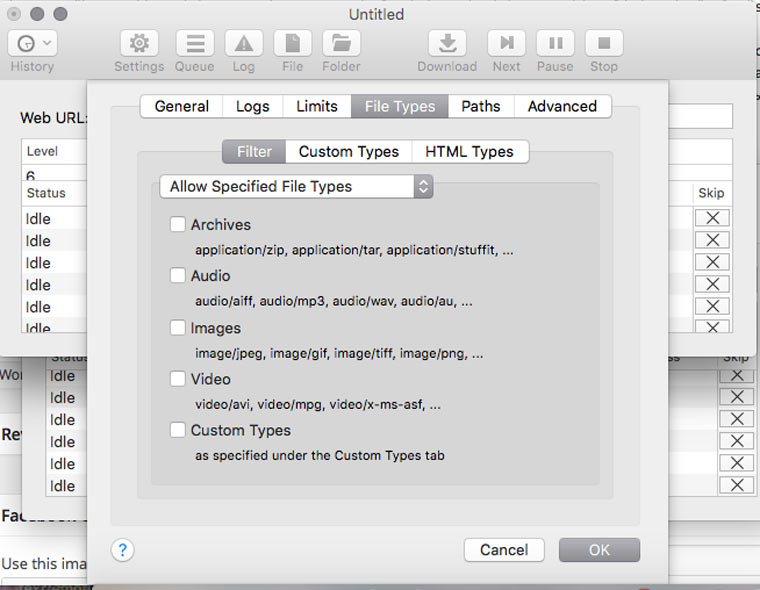

4. Скачиваем с сайта файлы определенного типа

В Settings -> File Types -> Filters можно указать какие типы файлов разрешено скачивать, либо какие типы файлов запрещено скачивать (Allow Specified Filetypes/Disallow Specifies Filetypes). Таким образом можно извлечь все картинки с сайта (либо наоборот игнорировать их, чтобы места на диске не занимали), а также видео, аудио, архивы и десятки других типов файлов (они доступны в блоке Custom Types) от документов MS Word до скриптов на Perl.

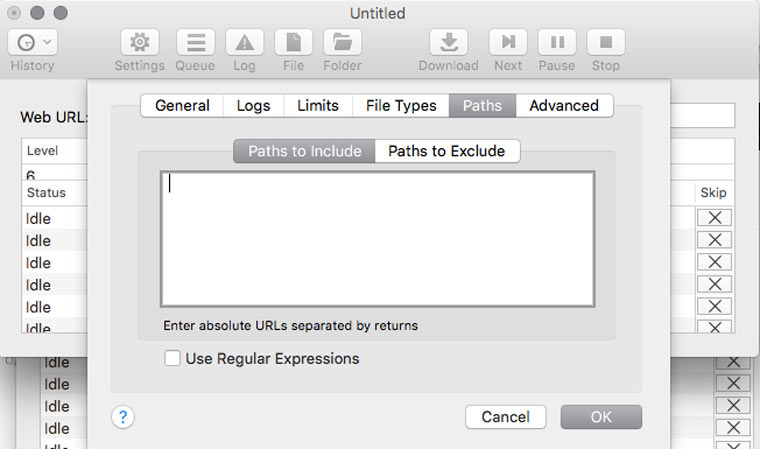

5. Скачиваем только определенные папки

Если на сайте есть книги, чертежи, карты и прочие уникальные и полезные материалы, то они, как правило, лежат в отдельном каталоге (его можно отследить через адресную строку браузера) и можно настроить SiteSucker так, чтобы скачивать только его. Это делается в Settings -> Paths -> Paths to Include. А если вы хотите наоборот, запретить скачивание каких-то папок, то их адреса надо указать в блоке Paths to Exclude

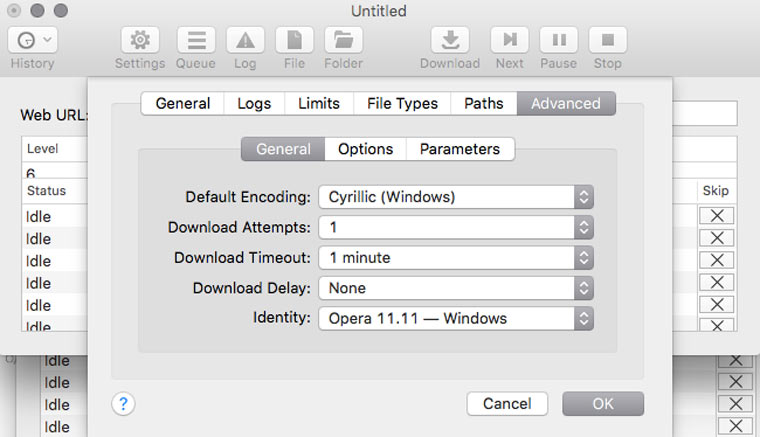

6. Решаем вопрос с кодировкой

Если вы обнаружили, что скачанные страницы вместо текста содержат кракозябры, там можно попробовать решить эту проблему, поменяв кодировку в Settings -> Advanced -> General. Если неполадки возникли с русским сайтом, то скорее всего нужно указать кодировку Cyrillic Windows. Если это не сработает, то попробуйте найти искомую кодировку с помощью декодера Лебедева (в него надо вставлять текст с отображающихся криво веб-страниц).

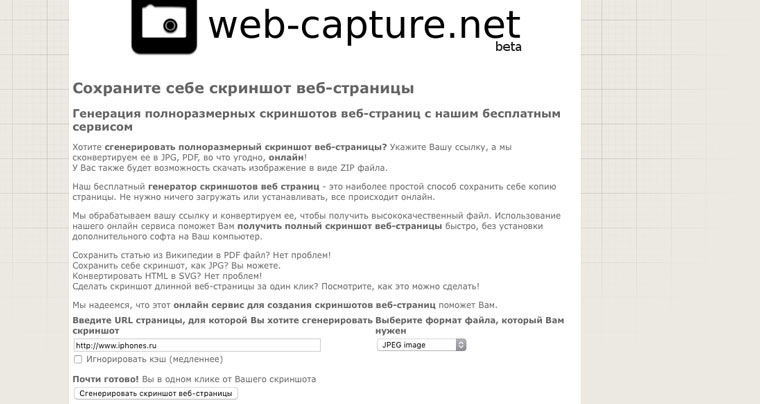

7. Делаем снимок веб-страницы

Сделать снимок экрана умеет каждый. А знаете ли как сделать снимок веб-страницы целиком? Один из способов — зайти на web-capture.net и ввести там ссылку на нужный сайт. Не торопитесь, для сложных страниц время создания снимка может занимать несколько десятков секунд. Еще это можно провернуть в Google Chrome, а также в других браузерах с помощью дополнения iMacros.

Это может пригодиться для сравнения разных версий дизайна сайта, запечатления на память длинных эпичных перепалок в комментариях или в качестве альтернативы способу сохранения сайтов, описанного в предыдущих шести пунктах.

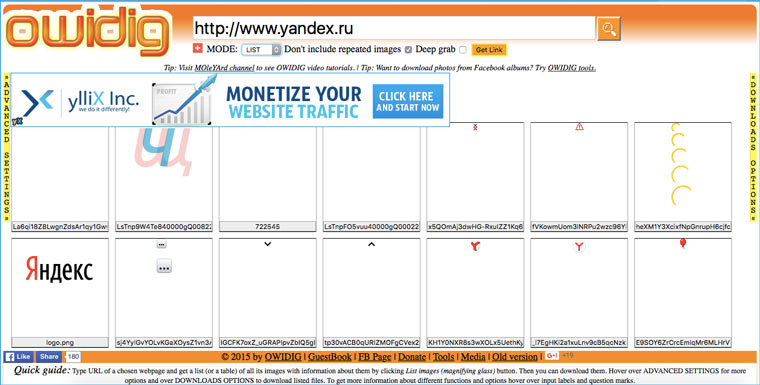

8. Сохраняем картинки только с определенной страницы

Идем на owdig.com, указываем нужную ссылку, ждем когда отобразятся все картинки и кликаем на оранжевую полоску справа, чтобы скачать их в архиве.

9. Извлекаем HEX-коды цветов с веб-сайта

Идем на colorcombos.com и набираем адрес искомой страницы и получаем полный список цветов, которые использованы на ней.

10. Извлекаем из текста адреса электронной почты

Предположим, что вам надо сделать рассылку по сотрудникам компании, а их email-адреса есть только на странице корпоративного сайта и копировать их оттуда в ручную займет лишние 20-30 минут. В такой ситуации на помощь приходит сервис emailx.discoveryvip.com. Просто вставьте туда текст и через секунду вы получите список всех адресов электронной почты, которые в нем найдены.

11. Извлекаем из текста номера телефонов

Идем на convertcsv.com/phone-extractor.htm, копируем в форму текст/html-код, содержащий номера телефонов и нажимаем на кнопку Extract.

А если надо отфильтровать в тексте заголовки, даты и прочую информацию, то к вам на помощь придут регулярные выражения и Sublime Text.

Есть и другие способы извлечения данных с сайтов. Можно попросить какую-ту информацию непосредственно у владельца ресурса, cохранять части веб-страниц с помощью iMacros и парсить сайты с помощью Google Apps Script. Еще можно пойти традиционным путем и написать для парсинга bash-скрипт, но статей об этом на iPhones.ru пока нет.

В закладки

БЕЗ скриптов, макросов, регулярных выражений и командной строки. Эта статья пригодится студентам, которые хотят скачать все картинки с сайта разом, чтобы потом одним движением вставить их в Power Point и сразу получить готовую презентацию. Владельцам электронных библиотек, которые собирают новые книги по ресурсам конкурентов. Просто людям, которые хотят сохранить интересный сайт/страницу в соцсети, опасаясь, что.

HTML парсер

Загружая файлы или используя наши сервисы Вы соглашаетесь с Условиями использования и Политикой конфиденциальности.

Узнайте больше о бесплатном онлайн приложении GroupDocs.Parser!

- Быстрый и удобный экстрактор текста и метаданных для HTML

- Извлеките текст HTML из любого места. Он работает со всех платформ, включая Windows, Mac, Android и iOS

- Извлечение текста из PDF, DOC, DOCX, RTF, HTML, EPUB, XLS, XLSX, PPT, PPTX и многих других форматов файлов и документов (см. список поддерживаемых форматов)

- Быстрый и удобный парсер штрихкодов для документов Штрихкод, DataMatrix, ISBN, MaxiCode, PDF417, Фармакод, QR код, VIN

- Используйте всю мощь GroupDocs.Parser для парсинга данных

Язык гипертекстовой разметки

HTML (Hyper Text Markup Language) — это расширение для веб-страниц, созданных для отображения в браузерах. HTML, известный как язык Интернета, развивался с учетом новых требований к информации, которая должна отображаться как часть веб-страниц. Последний вариант известен как HTML 5, что дает большую гибкость для работы с языком. HTML-страницы либо принимаются с сервера, на котором они размещены, либо также могут быть загружены из локальной системы.

Как извлечь текст и метаданные из файлов HTML

- Кликните по области загрузки или просто перетащите туда ваш файл HTML.

- После обработки HTML нажмите кнопку Загрузить сейчас.

- Так же вы можете отправить ссылку для скачивания данных на любой адрес электронной почты, нажав кнопку Email.

Другие форматы, поддерживаемые Parser App

Вы можете распарсить многие другие форматы. Полный список представлен ниже.